谷歌研究人员发论文揭GenAI正用虚假内容侵蚀网络

来源:倍可亲(backchina.com)腾讯科技讯 7月5日消息,据国外媒体报道,谷歌的研究团队日前发表了一篇引人注目的论文,指出生成式人工智能正在用虚假内容侵蚀互联网--这一现象颇具讽刺意味,因为谷歌自身也在积极向其庞大的用户群体推广这项技术。

这篇题为《生成式人工智能的滥用:现实世界数据中的策略分类与洞见》(Generative AI Misuse: A Taxonomy of Tactics and Insights from Real-World Data)的论文,由谷歌旗下的人工智能研究实验室DeepMind、安全智库Jigsaw以及慈善机构Google.org的研究人员联袂撰写。论文通过对2023年1月至2024年3月期间媒体和研究论文报道的约200起滥用案例进行分析,对生成式人工智能工具的滥用方式进行了分类和研究。

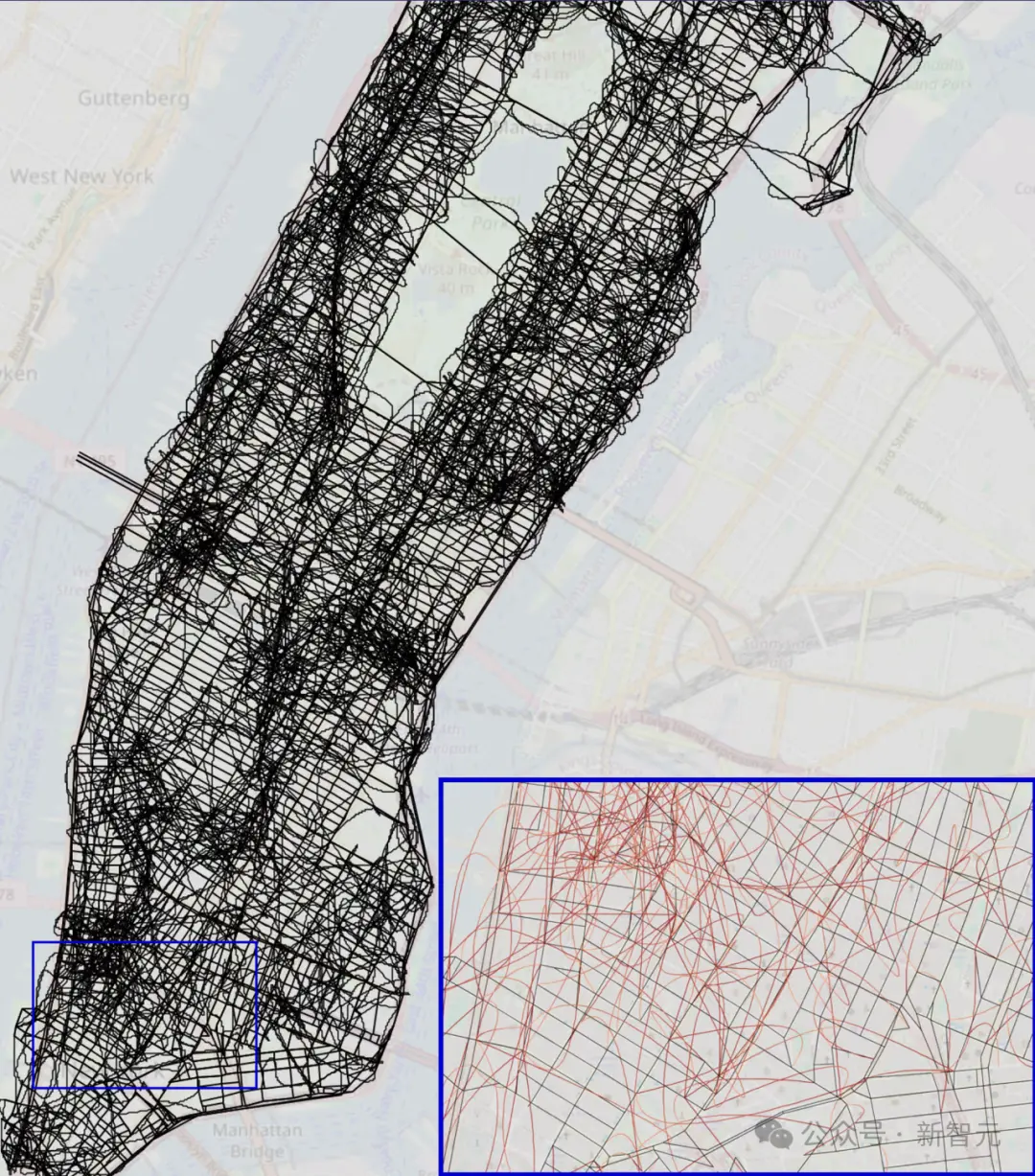

与OpenAI首席执行官山姆·奥特曼(Sam Altman)或埃隆·马斯克(Elon Musk)关于通用人工智能可能给人类带来的“生存风险”的警告不同,谷歌的研究更侧重于生成式人工智能目前对现实世界造成的具体伤害,以及这种伤害在未来可能进一步加剧的问题。具体而言,生成式人工智能极大地降低了在互联网上散布生成的含有虚假内容的文本、音频、图像和视频的难度。

谷歌研究团队使用的方法可能未充分统计人工智能生成内容所带来的伤害案例。不过该论文中最具启发性的发现是,这些伤害及其对“公众信任的侵蚀”,正如研究者所指出的:“既非公然恶意,也未明显违反这些工具的内容政策或服务条款”。换言之,此类内容的存在实际上是生成式人工智能的一个特点,而非缺陷。这项尚未经过同行评审的研究,揭示了绝大多数生成式人工智能用户正利用这项技术来“混淆真实性与欺骗之间的界线”,通过在互联网上发布伪造或篡改的人工智能生成内容,例如图像或视频。

研究人员总结称:“在现实世界中的滥用案例里,操纵人类形象和证据伪造是最普遍的策略。这些策略大多数是为了明显的目的而部署的,比如影响公众意见、促进诈骗或欺诈行为,或者是为了创造利润。”

读完这篇论文,读者难免会得出结论:所谓的“生成式人工智能的滥用”听起来更像是技术在按设计目标正常运作。人们利用生成式人工智能制造大量虚假内容,因为这项技术在这方面表现出色,结果导致互联网上充斥着由人工智能生成的低质量内容。这种情况在很大程度上是由谷歌自身促成的,它不仅允许虚假内容的扩散,有时甚至是这些内容的直接来源,无论是伪造的图像还是不实信息。研究人员指出,这种局面也在考验着人们辨别真假的能力。他们指出:“同样,大规模生产低质量、类似垃圾邮件和恶意合成内容,可能会增加人们对数字信息的普遍怀疑,并使用户在验证任务上感到不堪重负。”

研究论文中另一个值得关注的缺陷是,谷歌本身就是迅速开发和部署可能造成伤害的生成式人工智能工具的主要公司之一,最广为人知的例子是谷歌搜索中的AI概述回答,它曾错误地建议用户用胶水将芝士固定在披萨上。然而,研究人员并未对此进行深入探讨,而是指出所有参与或受影响的各方都应该采取更有效的措施。他们强调:“研究结果凸显了采取多管齐下的方法来减轻生成式人工智能滥用的必要性,这需要政策制定者、研究人员、行业领袖和民间社会的共同努力。”